【#アップルノート】 Appleの児童虐待画像検出は、何が問題視されているのか?

Appleは、iOS 15 / iPadOS 15 / macOS Montery / watchOS 8に対して、児童の性的虐待コンテンツ「CSAM」の検出に関する3つの新機能の導入を発表しました。これに対して、賛否が渦巻いており、Appleは対応に苦慮しています。

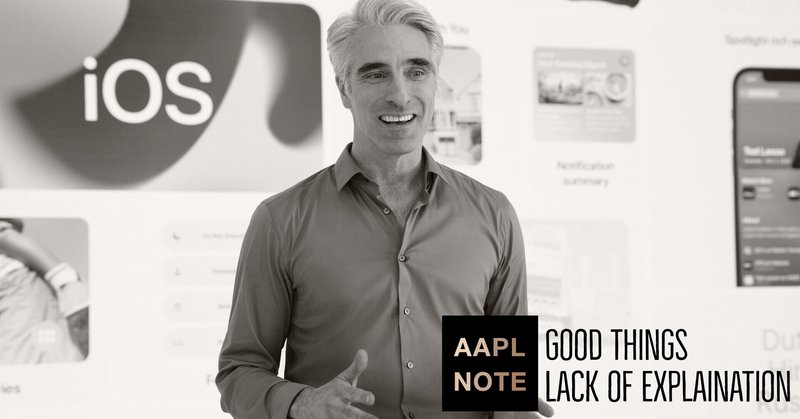

ソフトウェア開発のトップ、クレイグ・フェデリギ氏は、今回の発表について、説明不足、いくつかの機能をまとめて発表したことによる混乱によって、誤解が生じている点を指摘しています。

確かに、iOS 15に追加されるCSAM検出機能群としてまとめることができるのですが、デバイス側の検出機能、クラウド側の検出機能、検索行動に対する介入機能という3つの異なる機能が一緒に紹介されてしまい、かつクラウドでの検出機能はアカウントの停止や通報を伴うことが問題だったようです。

ここから先は

1,965字

この記事が気に入ったらサポートをしてみませんか?